Les tutoriels vidéo sur les messages Java consommateur/producteur entre serveur Kafka sont une excellente façon d’apprendre à maîtriser cette technologie. Découvrez comment configurer et utiliser cette technologie !

Comment envoyer et recevoir des messages entre un consommateur Java et un producteur et le serveur Apache Kafka dans cette série de tutoriels vidéo

Premier Paragraphe

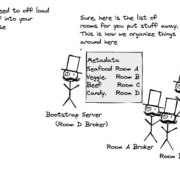

L’architecture Apache Kafka est un système de messagerie distribué qui peut être utilisé pour construire des applications de streaming et de traitement des données. Il est largement utilisé dans les applications de streaming et de traitement des données pour la mise en œuvre de pipelines de traitement des données complexes. Dans cette série de tutoriels vidéo, nous allons explorer la procédure d’envoi et de réception de messages entre un consommateur et un producteur Java et le serveur Apache Kafka. Nous allons également examiner le code Java pour consommer des messages à partir du serveur Apache Kafka.

Deuxième Paragraphe

Le code Java pour consommer des messages à partir du serveur Apache Kafka est assez simple. Tout d’abord, vous devez créer un objet KafkaConsumer et spécifier le type de données que vous souhaitez consommer. Ensuite, vous devez définir le serveur Apache Kafka sur lequel vous souhaitez envoyer les messages. Enfin, vous pouvez appeler la méthode subscribe () pour s’abonner à un sujet et commencer à recevoir des messages. Vous pouvez également spécifier le type de données que vous souhaitez recevoir à l’aide de la méthode subscribe ().

Troisième Paragraphe

Une fois que vous avez abonné un sujet, vous pouvez appeler la méthode poll () pour récupérer les messages du serveur Apache Kafka. La méthode poll () prend en charge plusieurs paramètres, notamment le temps d’attente maximal, le nombre maximum de messages à récupérer et le type de données à récupérer. Une fois que vous avez récupéré les messages, vous pouvez les traiter en fonction des besoins de votre application. Une fois que vous avez traité les messages, vous pouvez les envoyer à un autre serveur Apache Kafka ou les stocker dans un magasin de données.