SAP & Siemens jettent les bases d’un partenariat ambitieux : ouvrir la voie à de nouvelles opportunités, supprimer les silos et accélérer la transformation.

SAP & Siemens jettent les bases d’un partenariat ambitieux

Depuis l’annonce du partenariat signé entre SAP et Siemens le 14 juillet 2020, nous avons été ravis de voir à quel point les utilisateurs, partenaires et analystes adhéraient à cette initiative audacieuse et à notre ambition commune d’ouvrir la voie à de nouvelles opportunités, de supprimer les silos et d’accélérer la transformation. Tenir la promesse d’un retour sur investissement plus rapide, de processus de développement durables et de nouvelles opportunités métiers nécessite un nouveau niveau d’intégration. Et c’est ce dans quoi SAP et Siemens ont investi massivement – jusqu’à maintenant dans les coulisses.

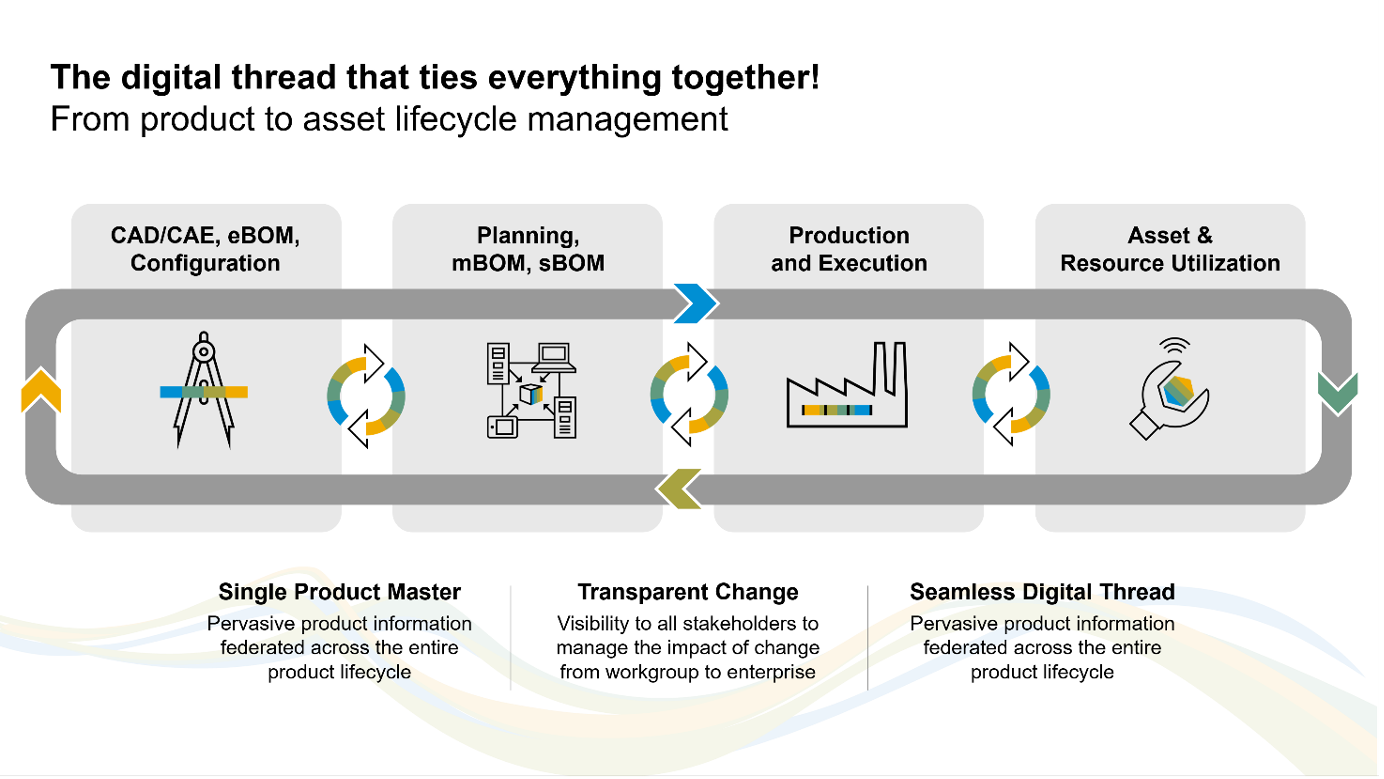

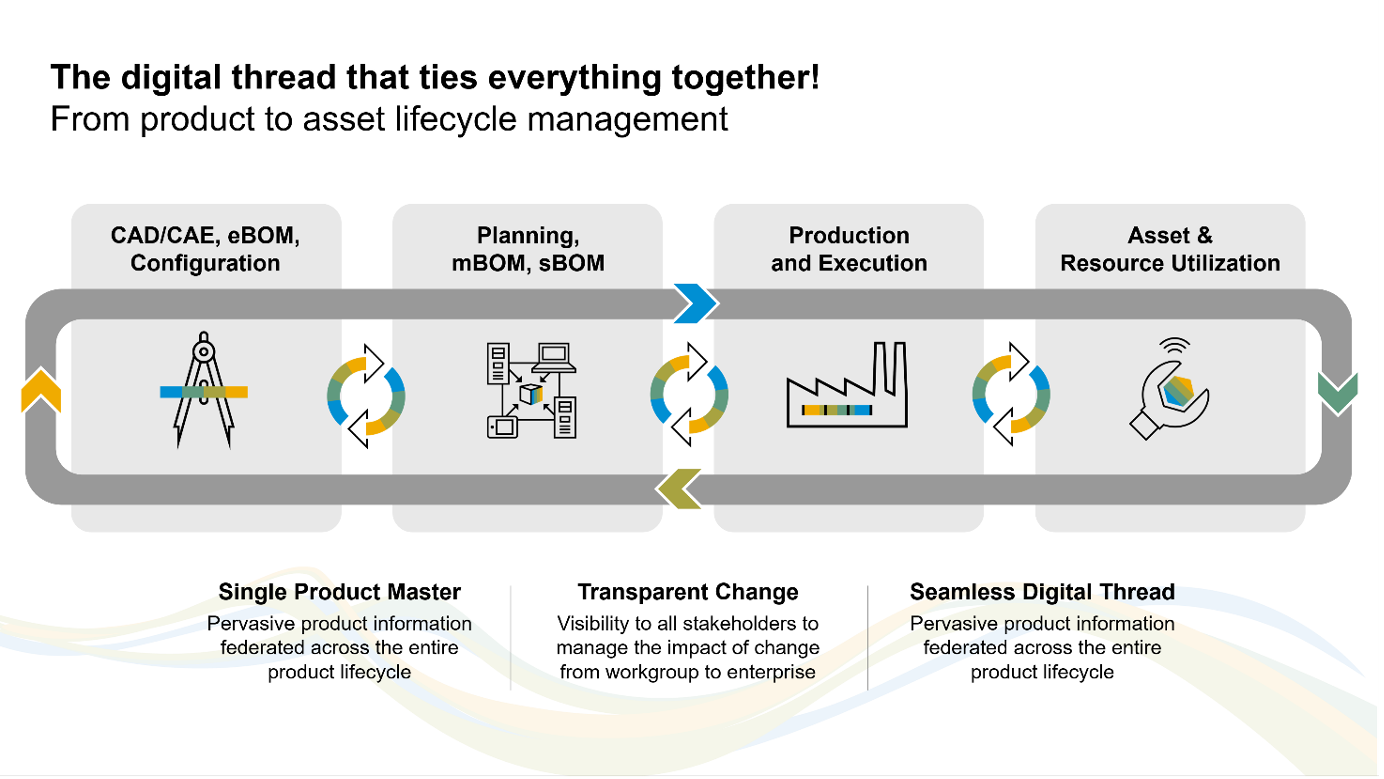

La continuité numérique requiert un meilleur niveau d’intégration

Nous savons que nos clients sont aujourd’hui mis au défi d’améliorer leur vitesse de mise sur le marché tout en créant des produits toujours plus complexes et de meilleure qualité. Bien que nos solutions offrent des capacités de pointe dans leurs domaines fonctionnels respectifs, le véritable bénéfice ne peut venir que d’une communication en boucle fermée native et transparente entre le développement produits et la gestion d’entreprise. C’est le cap que nous suivons conjointement :

Combiner l’expertise en intégration de SAP et Siemens

L’intégration entre les systèmes d’ingénierie et d’entreprise n’est pas un phénomène nouveau. Mais il reste complexe. Pourquoi ? Parce que se mettre d’accord sur un langage commun, des processus communs et les solutions et architectures techniques associées à travers tous les secteurs d’activité, les organisations et les réseaux est une tâche difficile. Sans compter les exigences propres à l’ingénierie, aux métiers, à l’informatique et à l’industrie.

Un partenariat stratégique tel celui que nous avons mis en place avec Siemens est une excellente occasion de résoudre certains de ces problèmes fondamentaux. Nous nous appuyons sur l’idée que nos systèmes d’ingénierie et d’entreprise seront égaux et adopteront le niveau d’interopérabilité et de visibilité nécessaire pour concrétiser l’idée de continuité numérique.

Un modèle de données unique : garant du succès

Un modèle de données aligné entre SAP et Siemens est à la base de l’intégration en tant que couche intermédiaire. Cet alignement est rendu possible grâce à un niveau d’abstraction des données qui seront échangées entre Siemens Teamcenter et l’ERP SAP S/4HANA. Ce modèle de données doit être compréhensible des deux côtés et dotée d’une sémantique claire, adaptée à toutes les implémentations.

Ce modèle de données aligné continuera à évoluer afin de permettre le développement de nouveaux scénarios d’intégration.

Aperçu de la feuille de route 2021-2022 : une innovation continue s’appuyant sur des fondations solides

Depuis l’annonce du partenariat, les équipes de développement de Siemens et SAP se sont réunies pour mettre en œuvre les principes évoqués ci-dessus. Elles ont commencé parse concentrer sur le développement d’un ’échange transparent des données produits, afin de permettre une intégration bidirectionnelle des processus. Puis ont mis l’accent sur une couverture de bout en bout de processus métiers spécifiques : en commençant par la fabrication sur stock (MTS), la configuration à la commande (CTO) et l’ingénierie à la commande (ETO).

Le résultat est une feuille de route définie conjointement, qui commence avec une première version programmée au quatrième trimestre 2021.

Etape 1 : intégration du PLM vers SAP

La première release s’appuiera sur notre modèle commun et les processus de bout en bout sous-jacents afin d’établir les fondations de permettant une traçabilité, une fédération des données et des liensinter systèmes. Elle se concentrera sur les processus et le transfert de données depuis le Teamcenter vers SAP, tels que :

- Création des fiches article dans SAP basés sur les sémantiques métiers

- Transfert des données de classification pour permettre un flux d’informations cohérent vers SAP

- Création des fiches info document dans SAP

- Transfert de la nomenclature vers SAP

- Capacité pour Teamcenter de déclencher des modifications en provenance de l’ingénierie

Etape 2 : élargir le scope et fermer la boucle entre le développement produit et SAP

Début 2022, la prochaine vague d’innovations se focalisera sur la « fermeture de la boucle » entre SAP et le développement produit. Nous nous concentrerons sur les fondations des processus métier avancés, y compris les scénarios de configuration à la commande (CTO), d’ingénierie à la commande (ETO), etc. Voici quelques fonctionnalités clés de cette version :

- Création de fiches articles et de nomenclatures spécifiques

- Capacité pour SAP de déclencher des changements d’ingénierie et de fabrication

- Transfert de la définition de la configuration des produits à variantes

- Fourniture de données pertinentes pour la fabrication tout au long du processus métier

- Transfert des gammes SAP

- Mise à disposition d’une solution cross système pour la gestion du portefeuille produits et projets (PPM)

Etape 3 : interopérabilité bidirectionnelle des systèmes et scénarios d’intégration avancés

Nous avons également prévu une seconde version en 2022, qui ne se concentrera pas seulement sur l’amélioration continue des processus avancés de configuration (CTO) et d’ingénierie (ETO), mais également sur une intégration bidirectionnelle favorisant transparence et interopérabilité. Les fonctionnalités proposées comprendront :

- Gestion des nomenclatures spécifiques à la commande dans SAP

- Échange de modèles produit pour la configuration de variantes et règles de contraintes d’ingénierie

- Mise à disposition de scénarios Engineering to Order (ETO) sans couture

- Échange d’informations sur les fournisseurs basés sur les informations fournisseurs

- Activation de la traçabilité inter systèmes pour les workflows

- Activation de l’analyse d’impact inter systèmes

Si vous souhaitez en savoir davantage sur notre feuille de route, rendez-vous dans les prochaines semaines sur le SAP Roadmap Explorer.

The post Feuille de route pour une intégration avancée entre SAP et Teamcenter appeared first on SAP France News.

Source de l’article sur sap.com