.

Explorer les threads virtuels Java peut être une route longue et difficile, mais avec un peu de persévérance, les résultats en valent la peine!

Il a fallu presque 30 ans. L’introduction de Threads Virtuels Java 1.21 rendra enfin le multitâche presque sans effort dans Java. Pour pleinement apprécier leur nature révolutionnaire, il est utile de jeter un coup d’œil aux diverses solutions imparfaites offertes par Java au fil des ans pour résoudre le problème « faire un travail utile pendant que nous attendons autre chose ».

Il a fallu presque 30 ans. L’introduction de Threads Virtuels de Java 1.21 rendra enfin la multitâche dans Java presque sans effort. Pour pleinement apprécier leur nature révolutionnaire, il est utile de jeter un coup d’œil aux différentes solutions imparfaites offertes par Java au fil des ans pour résoudre le problème «faire un travail utile pendant que nous attendons autre chose».

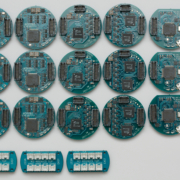

Java 1

L’introduction de Java version 1 en 1995 était remarquable. Un langage fortement typé, orienté objet et syntaxe similaire à C qui offrait de nombreuses fonctionnalités, y compris des Threads faciles à utiliser. La classe Thread représentait un objet qui exécuterait le code sélectionné dans un thread séparé du thread d’exécution principal. L’objet Thread était lui-même un wrapper pour un thread de niveau système d’exploitation réel connu sous le nom de thread de plate-forme, également appelé thread noyau. La logique à exécuter était décrite en implémentant une interface Runnable. Java s’occupait de toute la complexité du lancement et de la gestion de ce thread séparé. Maintenant, il sera presque trivial d’effectuer plusieurs tâches simultanément, ou du moins c’est ce qu’il semblerait. Considérez l’exemple suivant:

Les limites des threads

Malgré tous les avantages qu’offre Java, les threads ont leurs limites. Les threads sont très coûteux à créer et à gérer, et leur utilisation peut entraîner une surutilisation des ressources système et une augmentation des temps de latence. De plus, les threads ne peuvent pas être partagés entre plusieurs processus, ce qui signifie que le code doit être dupliqué pour chaque processus et gère indépendamment. Cela peut entraîner des problèmes de cohérence et de synchronisation entre les threads et les processus.

Pour résoudre ces problèmes, Java a introduit un certain nombre de solutions, notamment les threads légers, les threads poolés et les futures. Bien que ces solutions aient permis d’améliorer la gestion des threads, elles n’ont pas réussi à résoudre tous les problèmes liés à la gestion des threads et à l’utilisation des ressources système.

Cependant, avec l’introduction des Threads Virtuels de Java 1.21, ces problèmes sont enfin résolus. Les Threads Virtuels sont une solution plus efficace pour la gestion des threads qui offre une meilleure utilisation des ressources système et une meilleure gestion des threads. Les Threads Virtuels sont basés sur le concept de «threads légers» qui permettent aux développeurs de créer et de gérer facilement des threads sans avoir à se soucier des coûts associés à la gestion des threads. De plus