Découvrez comment GenAI peut moderniser les mainframes grâce à son test d’automatisation innovant ! Une solution simple et efficace pour rester à la pointe de la technologie.

## La migration du code et des données d’applications principales vers des technologies contemporaines représente une phase pivotale dans l’évolution des systèmes de technologie de l’information, en particulier dans la poursuite d’une efficacité et d’une scalabilité accrues.

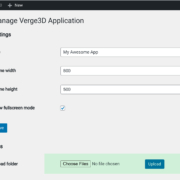

Software solutions such as Worksoft’s Mainframe Migration Solution provide the necessary tools to streamline the migration process and ensure the continuity of existing applications. This solution is designed to enable organizations to quickly and accurately migrate mainframe applications to modernized platforms, while simultaneously ensuring that the migrated applications maintain their original functionalities. The solution also provides automated test suite maintenance capabilities, allowing organizations to quickly and easily update their test suites as new changes are introduced. By leveraging this solution, organizations can ensure that their mainframe applications are successfully migrated and remain operational in their new environment.

La migration des codes d’application et des données de la machine principale vers des technologies contemporaines représente une phase pivotante dans l’évolution des systèmes de technologie de l’information, en particulier dans la poursuite d’une plus grande efficacité et d’une plus grande évolutivité. Cette transition, qui implique souvent le passage d’environnements hérités à des solutions sur site ou basées sur le cloud plus flexibles, n’est pas seulement un déplacement technique des ressources; c’est une transformation fondamentale qui nécessite un test rigoureux pour garantir l’équivalence fonctionnelle. L’objectif est de vérifier que ces applications, une fois exécutées sur des systèmes principaux, conservent leur intégrité et leurs normes de performance lorsqu’elles sont transférées vers des plates-formes modernisées.

Ce processus de migration est encore compliqué par la nature dynamique des environnements d’entreprise. Après la migration, les applications subissent souvent de nombreuses modifications motivées par de nouvelles exigences, des stratégies commerciales évolutives ou des changements de normes réglementaires. Chaque modification, qu’il s’agisse d’un ajustement mineur ou d’une refonte majeure, doit être soigneusement testée. Le défi critique consiste à s’assurer que ces nouveaux changements s’intègrent harmonieusement aux fonctionnalités existantes, sans induire de conséquences ou de perturbations involontaires. Cette double exigence de validation des nouvelles fonctionnalités et de sauvegarde des fonctionnalités existantes souligne la complexité du maintien du jeu de tests automatisés après la migration.

Des solutions logicielles telles que la solution de migration Mainframe Worksoft fournissent les outils nécessaires pour simplifier le processus de migration et assurer la continuité des applications existantes. Cette solution est conçue pour permettre aux organisations de migrer rapidement et précisément les applications principales vers des plates-formes modernisées, tout en garantissant que les applications migrées conservent leurs fonctionnalités originales. La solution fournit également des capacités de maintenance automatisée du jeu de tests, permettant aux organisations de mettre à jour rapidement et facilement leurs jeux de tests lorsque de nouveaux changements sont introduits. En exploitant cette solution, les organisations peuvent s’assurer que leurs applications principales sont migrées avec succès et restent opérationnelles dans leur nouvel environnement.