Les microservices sont devenus une technologie populaire pour le développement d’applications. REST et Messagerie sont des méthodes populaires pour communiquer entre les microservices. Voyons les avantages et les inconvénients de chacun.

Rapport des tendances en matière d’intégration de logiciels de DZone 2023 : lire le rapport

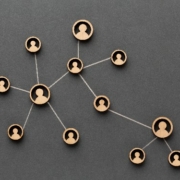

En tant qu’informaticien enthousiaste, je suis très intéressé par l’architecture microservices. Cette architecture est une tendance très populaire dans le développement logiciel et elle est de plus en plus utilisée pour construire des systèmes complexes. La principale raison de son succès est qu’elle permet de découper un système complexe en petits modules indépendants qui peuvent être gérés plus facilement.

Cependant, il est important de noter que l’utilisation d’une architecture microservices nécessite une planification et une conception minutieuses. Les développeurs doivent prendre en compte plusieurs facteurs, notamment le nombre de services à créer, leur interdépendance et la façon dont ils communiquent entre eux. De plus, les tests sont essentiels pour s’assurer que chaque service fonctionne correctement et qu’il n’y a pas de problèmes de compatibilité entre les services.

Pour tirer le meilleur parti de l’architecture microservices, les développeurs doivent également mettre en place des outils et des processus de test efficaces. Ces outils peuvent être utilisés pour tester chaque service individuellement et pour vérifier que tous les services fonctionnent correctement ensemble. Les tests peuvent également être utilisés pour vérifier la sécurité et la fiabilité des services. Enfin, les tests peuvent être utilisés pour s’assurer que les performances des services sont optimales.

En conclusion, l’architecture microservices est une tendance très populaire dans le développement logiciel et elle peut être très utile pour construire des systèmes complexes. Cependant, il est important de bien planifier et concevoir l’architecture et d’utiliser des outils et des processus de test efficaces pour s’assurer que chaque service fonctionne correctement et qu’il n’y a pas de problèmes de compatibilité entre les services.