Commençons à gérer nos journaux pour mieux organiser notre quotidien et atteindre nos objectifs plus facilement !

La réalité de la conception d’applications modernes signifie que lorsqu’un problème inattendu se produit, la capacité de trouver la cause racine peut être difficile. C’est là que le concept de gestion centralisée des journaux peut fournir une grande assistance. Cette Refcard vous apprend le flux de base d’un processus de gestion des journaux, fournit une liste de contrôle complète des questions à considérer lors de l’évaluation des solutions de gestion des journaux, vous conseille sur ce que vous devriez et ne devriez pas tracer et couvre les fonctionnalités avancées pour la gestion des journaux.

La réalité de la conception moderne des applications signifie que lorsqu’un problème inattendu se produit, il peut être difficile de trouver la cause racine. C’est là que le concept de gestion centralisée des journaux peut fournir une grande assistance. Cette Refcard vous apprend le flux de base d’un processus de gestion des journaux, fournit une liste de contrôle complète des questions à considérer lors de l’évaluation des solutions de gestion des journaux, vous conseille sur ce que vous devriez et ne devriez pas journaliser et couvre les fonctionnalités avancées pour la gestion des journaux.

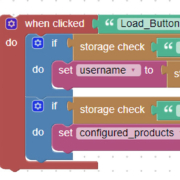

Le codage est un élément essentiel de la gestion des journaux. Les outils de codage permettent aux développeurs d’ajouter des informations supplémentaires aux journaux afin qu’ils puissent être analysés plus facilement et plus rapidement. Les outils de codage peuvent également aider à identifier les tendances et à déterminer les causes racines des problèmes. Les outils de codage peuvent être intégrés à un système de gestion des journaux pour fournir des informations supplémentaires sur les performances et les erreurs.

Les outils de codage peuvent également être utilisés pour surveiller et analyser les journaux à des fins prédictives. Par exemple, les outils de codage peuvent être utilisés pour surveiller les tendances et les modèles dans les journaux afin d’identifier les problèmes potentiels avant qu’ils ne se produisent. Les outils de codage peuvent également être utilisés pour surveiller les performances et le comportement des applications afin d’identifier les problèmes et d’améliorer les performances. Enfin, les outils de codage peuvent être utilisés pour créer des rapports personnalisés qui peuvent être utilisés pour prendre des décisions informées sur la façon dont une application doit fonctionner.