Les flux d’événements sont une chose, mais sans action, ils ne servent à rien. Il est donc important de passer à l’action pour tirer le meilleur parti des opportunités qui se présentent.

Événements de flux et traitement des flux d’événements

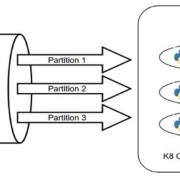

En tant qu’informaticien enthousiaste, je voudrais discuter des flux d’événements et du traitement des flux d’événements en profondeur. Chaque point de données dans un système qui produit des données de manière continue correspond à un événement. Les flux d’événements sont décrits comme un flux continu d’événements ou de points de données. Les flux d’événements sont parfois appelés flux de données dans la communauté des développeurs, car ils se composent de points de données continus. Le traitement des flux d’événements fait référence à l’action prise sur les événements générés.

Le traitement des flux d’événements est très différent du traitement par lots, car le traitement des flux d’événements est conçu pour traiter les données en temps réel. Cela signifie que les données sont traitées immédiatement après leur arrivée et que les résultats sont immédiatement disponibles. Cela permet aux systèmes de prendre des décisions en temps réel et de réagir rapidement aux changements. Les avantages du traitement des flux d’événements comprennent une meilleure prise de décision, une plus grande réactivité et une plus grande efficacité.

Le traitement des flux d’événements est utilisé pour une variété de tâches, notamment la surveillance en temps réel, le routage et le filtrage des données, l’analyse prédictive et la détection des anomalies. Par exemple, un système peut surveiller en temps réel les données provenant d’une base de données et prendre des mesures en fonction des résultats obtenus. Il peut également être utilisé pour analyser les données en temps réel et prendre des décisions basées sur ces analyses. Enfin, le traitement des flux d’événements peut être utilisé pour détecter les anomalies dans les données et prendre des mesures pour y remédier.

Pour illustrer le traitement des flux d’événements, considérons un système qui surveille en temps réel les données provenant d’une base de données. Le système surveille les données à l’aide d’une application qui analyse les données et prend des mesures en fonction des résultats obtenus. Lorsque le système détecte une anomalie, il peut prendre des mesures pour corriger le problème ou avertir l’utilisateur. De plus, le système peut être configuré pour analyser les données en temps réel et prendre des décisions basées sur ces analyses. Ainsi, le traitement des flux d’événements permet aux systèmes de surveiller, analyser et prendre des décisions basées sur les données provenant d’une base de données en temps réel.